可编程仿人机器人虚拟仿真实验可完成以下任务

1.语言识别虚拟仿真实验

2.人脸识别虚拟仿真实验

3.目标跟踪虚拟仿真实验

4.舞蹈动作虚拟仿真实验

实验列表

序号 |

实验名称 |

实验简介 |

实 类别 |

学时 |

1 |

可编程仿人机器人虚拟仿真系统开发 |

操作机器人进行如下功能的开发 :.语言识别;.人脸识别;目标跟踪;.舞蹈动作。 |

应用开发 |

40 |

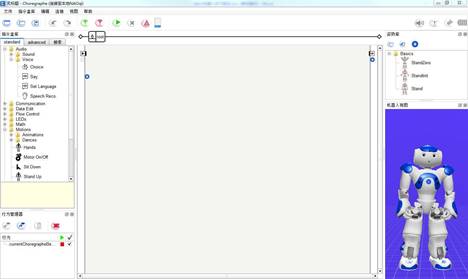

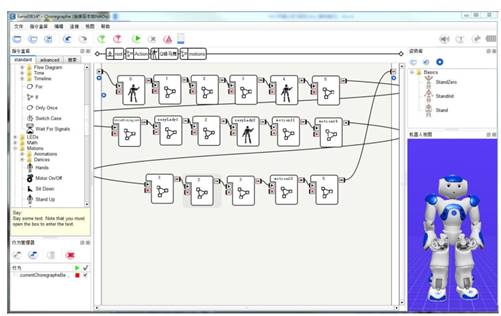

图1 机器人虚拟仿真实验教学平台界面

分步骤完成相应的功能,实训主要步骤如下,

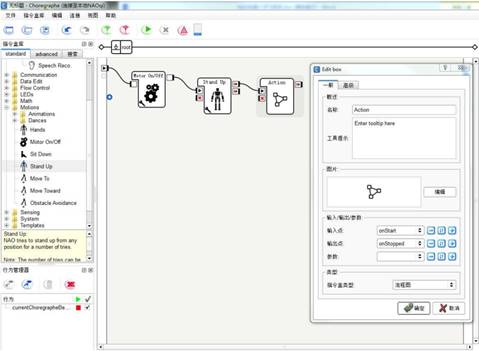

(1),建立一个新项目、命名和保存→拖拽(按住鼠标左键不放)“Motor On/Off”和“Stand Up”指令盒到编程区→点击鼠标右键选择“添加一个新指令盒”,并命名为“Action”,指令盒类型设为“流程图”→各指令盒的连接如下图:

图2 新建动作

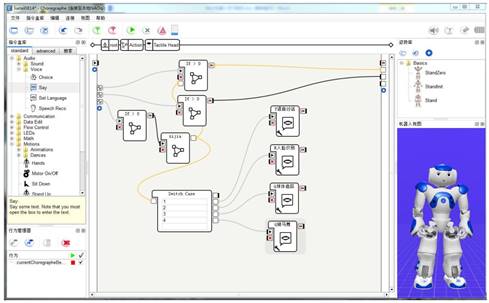

(2)头部按钮设置,双击自定义的“Action”指令盒→拖拽“Tactile Head”指令盒到编程区→选中“Tactile Head”指令盒,点击鼠标右键选择编辑指令盒,将输入点“frontTouched”和输出点“onStopped”的类型改为“数字”→双击“Tactile Head”指令盒(创建头部按钮功能,机器人头部的三个按钮分别实现三个功能,前触摸按钮实现开始程序功能、头顶触摸按钮实现暂停功能、后触摸按钮实现选择翻页功能)在四个“Say”指令盒中分别输入:语音对话、人脸识别、球体追踪和骑马舞等功能,结果如下图所示。

图3 头部按钮设置

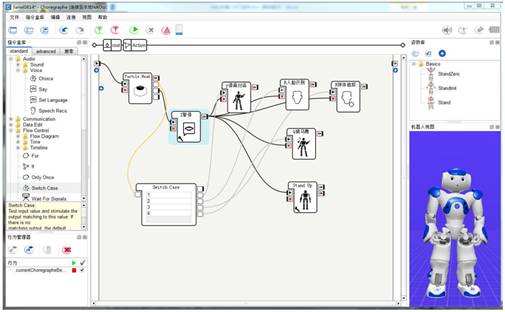

(3)点击中上方的“Action” →从指令盒库中,拖入“Say”box、“Switch Case”box和“Stand Up”box 各一个→将“Say”改名为“Z 暂停”,同时将说话内容也改为“暂停”→添加四个新的指令盒分别命名为:“Y 语音对话”、“R 人脸识别”、“Q 球体追踪”和“Q 骑马舞”,指令盒类型全部为“流程图”,结果如下图所示。

图4 指令连接

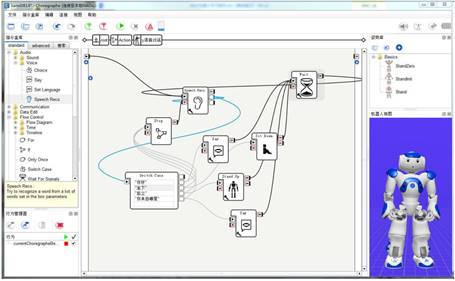

(4)语音对话编辑,双击“Y 语音对话”Box,从指令盒中拖入一个“Speech Reco”指令盒,并点击其左下角的小扳手,在弹出的参数设置,从指令盒库中拖入一个“Switch Case”Box,一个“StandUp”Box,一个“Sit Down”Box;两个“Say”Box 的内容分别输入相应指令,连接详情见下图。

图5 语音对话编辑

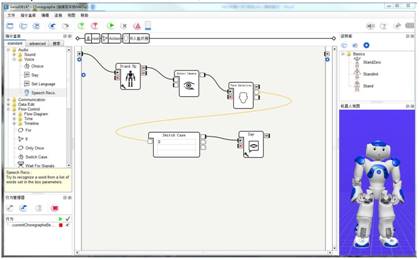

(5)人脸识别编辑,双击“R 人脸识别”Box→从指令盒库中拖入“Stand Up”Box、“Select Camera”Box、“Face Detection”Box、“Switch Case”Box 和“Say”Box 各一个→将“Say”Box 的说话内容改为“你好,人类”,连接详情见下图。

图6 人脸识别编辑

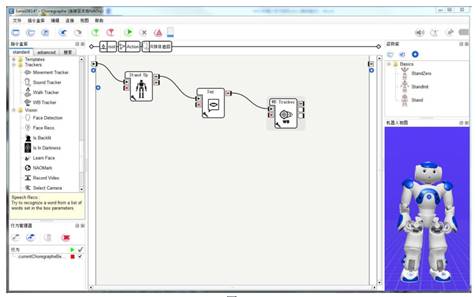

(6)球体追踪编辑,双击“Q 球体追踪”指令盒→拖入“Stand Up”、“Say”和“WBTracker”指令盒各一个→将“Say”Box 的内容改为“进入球体追踪模式,手持红球在距离我眼睛 40 厘米的地方缓慢移动” →点击“WB Tracker”Box 左下角的小扳手,在弹出的参数设置对话框中选择“Red Ball” ,连接详情见下图。

图7 球体追踪编辑

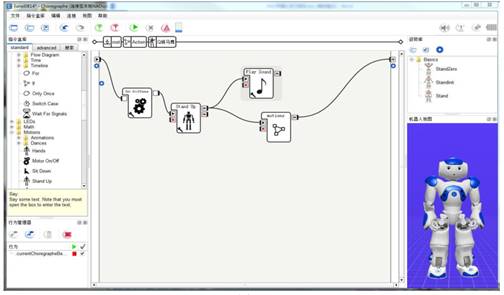

(7)舞蹈编辑,双击“Q 骑马舞”→拖入“Motor On/Off”、“Stand Up”和“Play

Sound”Box 各一个→点击“Play Sound”Box 左下角的小扳手,导入相关的音乐文件→创建一个新的指令盒,命名为“Motions”,类型设为“流程图”→连接见图 13→双击“Motions”指令盒,创建一系列新指令盒(见图 14),指令盒类型选择为“时间轴”→双击第一个新建的指令盒,将指针移动到“第 14 帧”,在机器人视图中点击相应的关节,在弹出的“动作”框中移动相关的滑块完成舞蹈动作的编辑→选中“第 14 帧”点击鼠标右键,选择“在关键帧中存储关节/全身” →依次编辑其它关键帧,并将最后一帧设为“结束帧”,连接详情见下图。

图39舞蹈编辑

图8 舞蹈动作编辑